Web環境の変化に伴い独自のアクセス解析サービスの提供が難しくなってきました。

17年前に開発した自社のアクセス解析ツールもだましだまし使ってきましたがそろそろ限界を迎えたようです。

アクセス解析関連の外部環境の変化を振り返ってみます。

広告からのアクセスが一般的になった

リリース当初はアクセス解析の約はりSEOの効果測定やコンバージョンからの成功パターン分析でした。

検索結果連動広告(言い方が古い)やディスプレイ広告からアクセスが増え、アクセス解析側でもURLパラメータから広告経由からのアクセスを判断できるように広告用パラメータの登録と振り分けが必要になりました。

また、パラメータ付アクセスが増えたため、集計の際にパラメータをつけたままの集計とパラメータを外したうえでの集計が必要になりました。

検索サイトがリファラ情報にキーワードを含ませなくなった

アクセス解析ではアクセスキーワードの把握が可能でした。

リファラとなるURLにURLエンコードされたキーワードが含まれていました。

これを利用してアクセスキーワードの統計を行っていましたが、個人情報保護の観点からなぜかこのキーワードを送るのをGoogle、Yahooともにやめてしまいました。

以前は問い合わせがあった場合に最初にどのようなキーワードで検索してからの訪問かが把握できたため、問い合わせ者のニーズを把握した上で商談を行うことができましたが、この施策によりコンバージョンとキーワードを組み合わせた検証ができなくなりました。

httpのページからhttpsページへ遷移する際にリファラを渡さなくなった

さらにhttpページからhttpsページに遷移した際にリファラ情報そのものを送らなくなりました。

どのURLから訪問してきたかもわからなくなり、まるでブックマークからの訪問のように見えるようになりました。

botによるアクセスが増えた

以前はクローラーと呼ばれる検索サイトからのコンテンツチェック用のアクセスが多かったのですが、まったく知らないURLからのアクセスが増えました。しかもメジャー検索サイトと違い一気にアクセスされるため、統計情報に影響を与えることが多くなりました。

SNSからのアクセスが増えた

SNSが普及しTwitterやFacebook、Youtubeからのアクセスも増えました。

こちらもリファラ情報が改ざんされているため、どのページからアクセスされたかを判明できず、どのようなきっかけで訪問しているのかが把握できないアクセス記録となりました。

クローラーがJavaScriptに対応した

Googleのクローラー(ロボット)がJavaScriptに対応したのに気づかず、アクセスが増えたように見えたのには困らせられました。今まではロボットからのアクセスは除外できていたのが毎日少しずつアクセスされ、暫くの間正確なアクセス数が把握できなくなりました。

CDNなどを経由したアクセスが増えた

cloudflareなどのCDN経由でのアクセスはキャッシュが機能するせいか正確な情報がとれないことが多々ありました。

タグをキャッシュさせないようにして対応したり、ページタイトルを取得するには端末のフリをしてページにアクセスする必要がありました。

サードパーティークッキーを受け付けなくなった

終了を決定したのはこのサードパーティークッキーの廃止です。

クッキーを利用して同一訪問者であるか認識していたのにこれによりコンバージョン検証が正確にできなくなりました。

今後

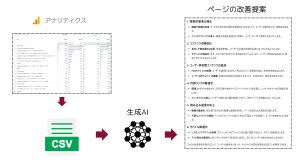

CMSを導入しているユーザーは個別のファーストパーティークッキーを利用したアクセス解析をCMSに搭載し、個別セッションのトレースなどは同一Webサーバー上で行うことにしました。

統計はGA4とLookerStudioを活用して行います。

LookerStudioがGA4のセグメントを利用できないので、なにかと工夫する必要がありますが、TagManagerでイベントを送ったりして錯誤している最中です。

Webの毎月の通知表といえるアクセスレポートを顧客に送付するため、私にとってはアクセス解析ツールはなくてはならないものですが、サービスとしての提供は今期で終了となりました。

GA4とFireBaseを使えば既存と同じ機能をつくれそうな感じなのですが、アクセス元が外部になるとこちらの想定外の修正で使えてきた機能が使えなくなるリスクがあるため、サービスとしての提供はあきらめました。